Philip Tetlock i Dan Gardner w swojej kapitalnej książce “Superforecasting, the art and science of prediction” , przytaczają słynną łamigłówkę Enrico Fermiego.

Stroiciele fortepianów w Chicago

A zatem, ilu jest tych stroicieli? To pytanie zadał Enrico Fermi swoim studentom, w latach 40-tych ubiegłego stulecia, jako ćwiczenie z logicznego myślenia. O raaany.. serio? To co? Zgadujemy? Niekoniecznie. Od czego może zależeć taka liczba takich specjalistów w Chicago? Pewnie od tego jaki na to jest popyt? Spróbujmy zebrać fakty, czyli:

- Ile jest fortepianów w Chicago?

- Jak często fortepian powinien być strojony w ciągu roku?

- Ile czasu trwa wykonanie takiej usługi?

- Ile przeciętnie, w ciągu roku, taki stroiciel spędza w pracy na dostawie takiej usługi?

Teraz zamiast zgadywać odpowiedź na pierwsze pytanie, spróbujmy wyestymować odpowiedzi na powyższe pytania szczegółowe. A właściwie prześledzić tok myślenia pana profesora Fermiego (nie mającego dostępu do Googla i takich tam):

- W latach 40-tych (Fermi uciekł z Włoch w 1938 roku), Chicago było trzecim co do wielkości miastem w USA. Po Nowym Jorku i Los Angeles. LA miało ok. 4mln mieszkańców. No to Chicago nie mogło mieć więcej, zakładając, że różnica między Chicago a kolejny miastem na liście, nie była wielka, to z prawdopodobieństwem ok. 90% przyjmijmy, że przedział ten to ok. 3,5mln - max, i 1,5mln min; Spotkajmy się gdzieś w środku i przyjmijmy - że Chicago ma ok. 2,5mln. Dalej już zgadujemy najlepiej jak możemy, w latach 40-tych tak samo jak teraz, fortepian to dość kosztowny instrument i niewielu było na nie stać, część mogła odziedziczyć w spadku, kupić używany.. zgadujmy: niech będzie że 1 rodzina na 100 miała jakiś fortepian (nowy, stary, używany). Dochodzą jeszcze instytucje - szkoły muzyczne, tańca, bary, restauracje, filharmonia, teatry, sale koncertowe, znowu zgadujemy, ale podwoimy tę liczbę - a zatem 2 na 100. Mamy więc 2,5mln * 2% - wychodzi ok. 50 tys. fortepianów.

- Ile razy w roku powinien być strojony fortepian, nie wiem - kogo stać, stroi częściej, kogo nie stać, rzadziej .. pewnie instytucje typu szkoły muzyczne czy sale koncertowe - częściej, ale rodziny, czy bary rzadziej - w barach i tak jest gwar, rodziny mogą oszczędzać.. przyjmijmy raz na rok.

- Ile trwa taka usługa? Pewnie to zależy od stanu fortepianu, przyjmijmy średnio 2h.

- No teraz to pewnie 40h tygodniowo. Daje nam to 40h na tydzień, razy 52 tygodnie, minus powiedzmy - święta i jakieś wakacje - więc 50 tygodni. Zostały dojazdy, Chicago to i wtedy było spore miasto i czas podróży (dojechać do, wrócić, itd.) - więc odejmijmy dwa tygodnie na rok (2h dziennie x 5 =10h/tydzien, czyli kolejne 500h w roku, po uwzględnieniu wakacji i świąt. 40 razy 50 daje nam to 2000h - 500h, daje nam to średnio 1500h w roku.

No to teraz mamy 50 tysięcy fortepianów razy 2h na każdy to daje 100 000 fortepianostrojeniogodzin na rok. Podzielmy to przez 1500. Wychodzi 66,66 - zaokrąglamy: 67 stroicieli fortepianów i pianin w Chicago. Amerykański psycholog Daniel Levitin, zadał sobie trud i po analizie adresów, numerów telefonów z archiwów telefonicznych książek z Chicago, ustalił, że było to ok. 83 takich usługodawców. Całkiem blisko.

Coś z podwórka IT

Tacy już jesteśmy, że szybko formułujemy zdanie na jakiś temat (jeszcze szybciej, jeśli zapytają nas jako eksperta), a dość wolno potem idzie nam tegoż zdania zmiana.

Jeśli logi z rutera i firewalla mają razem 11GB, a te z firewalla mają o 10GB więcej niż te z rutera, to ile mają te z rutera? ..Szybka odpowiedź: …no i kto odpowiedział 1GB? :-) a przecież:

- ruter+firewall = 11

- firewall = ruter+10

więc ruter = 0,5

No to ile mają?

te z firewalla: 10,5GB a te z rutera 0,5GB.

Co lubią tygrysy

W literaturze (D. Kahnemana “Thinking fast and slow”), którą panowie Tetlock i Gardner przytaczają w swojej książce, nazywa się to “snap judgement” albo “little evidence - conclusion”. Tak już jesteśmy stworzeni, że szybko myślimy opierając się głównie na intuicji i emocjach (tzw. “gut feeling”), myślimy też wolno oczywiście w sposób bardziej skomplikowany, ale kiedy mamy na to czas i komfort. Ponoć dawno temu, kiedy ludzkość dopiero zeszła z drzew i zamieszkiwała rajskie sawanny musiała sobie jakoś radzić, by przeżyć. Nie pozakładała jeszcze wtedy uniwersytetów, więc na temat przeżycia doktoratów jeszcze nie było, ale były proste schematy - wieczorne ognisko, aż wtem!… szum w krzakach i jakiś cień. Nie było czasu na analizy stochastyczne, więc wszyscy “chodu!” - brali nogi za pas. Naturalnie, komuś się mogło przewidzieć, ktoś mógłby zakrzyknąć “eeej! hola, hola… nie, no przemyślmy, jest ognisko, jest ciepło, możebyśmy się poroz…”. Rzeczywistość jednak była taka, że statystycznie taki mędrek nie dożywał poranka. A my jako gatunek z aspiracjami, musieliśmy jednak jakoś przeżyć. Zatem “gut feeling” na bazie wcześniejszych doświadczeń i wspomnień (kiedy takiego mędrka coś jednak zjadło) ma jak najbardziej sens. Jakoś tak mamy, że jeśli nasz mózg oceni poziom “zagrożenia” (na podstawie stresu, podniesionego ciśnienia, skojarzeń i innych psychologicznie wyjaśnialnych czynników i bodźców) na wysoki lub krytyczny - włącza nam się to myślenie pierwotne.

Czego nie lubią ludzie

Ludzie nie lubią ekspertów, których wynajęli, lubo też takich którzy sami się wprosili na spotkanie (po 30 telefonach i 50-ciu emailach), a którzy odpowiadając na zadane pytania, jąkają się mówiąc “eeeee…”, “jakby..”, “toooo zaleeeeży..”. Ludzie nie lubią dostawać rozwlekłych skomplikowanych, złożonych ze zdań zależnych, a nawet i ukrytych tez (i oskarżeń!), odpowiedzi .. na zadane skomplikowane, złożone ze zdań zależnych, a nawet i ukrytych tez (i oskarżeń!) pytania. Ludzie lubią, proste i klarowne odpowiedzi, sformułowane precyzyjnie, pewnym i spokojnym głosem.

Jak to jest z tym ryzykiem

“The first principle is that you must not fool yourself, and you are the easiest person to fool”

(Richard Feynman)

Wiadomo powszechnie, że ryzykiem bezpieczeństwa IT, czy też nawet cyberbezpieczeństwa zajmują się eksperci, mający dostarczyć możliwie precyzyjne informacje, na bazie których przedsiębiorstwa podejmują później ważkie decyzje i wydają spore pieniądze.

Co to jest ryzyko? Ryzyko to jest niepewność, wobec której dopytujemy “ale ile można na tym stracić”? Ryzyko w bezpieczeństwie IT, to niepewność co do wystąpienia w czasie i wielkości strat spowodowanych zagrożeniami, które czyhają na nasze przepracowane i niedoinwestowane IT (mające znane i nieznane słabości - w organizacji, w procesach i w technologiach). Gra idzie o to by tę niepewność zredukować do policzalnych i zrozumiałych dla ludzi wartości, dzięki którym podejmujący decyzję, będą w pełni rozumieli przesłanki i podstawy swoich decyzji.

Wobec powyższego, wydaje się, iż zarządzanie ryzykiem jest taką redukcją niepewności, aby móc ustalić w sposób policzalny zbiór takich możliwych scenariuszy, gdzie prawdopodobieństwo wystąpienia takiego scenariusza będzie oszacowane policzalnie i konsekwentnie straty materialne również. Na przykład: Ustaliliśmy, że z prawdopodobieństwem wystąpienia 5% w ciągu roku, możemy doświadczyć straty z tytułu wycieku danych, która będzie nas kosztować 2 mln PLN z tytułu postępowań, odszkodowań, kar itd. Chwila, chwila .. czy to znaczy, że ryzyko jest HIGH czy MEDIUM, a może CRITICAL skoro taka kwota? Nie, to znaczy, że mamy 5 szans na 100 w ciągu roku, że poniesiemy stratę 2mln PLN. I kropka. Nie przez przypadek zacząłem wpis od przykładów z fortepianem, firewallem i ruterem. Estymacje i analizy doprowadzające nas do sensownych wyników zależą od nas samych - w jaki sposób rozłożymy złożone pytanie na pytania prostsze (np. Jakie jest prawdopodobieństwo wystąpienia straty w wysokości X w przypadku zagrożenia ABC i wad oraz podatności w systemie DEF..) a potem jak się zabierzemy za analizę i syntezę wyników, i co najważniejsze - czy pójdziemy na skróty wobec samych siebie, czy nie.

Pułapki na tygrysy

Wszyscy wiemy, że metody szacowania ryzyka nazywane powszechnie jakościowymi, bądź eksperckimi są też powszechnie stosowane (jeśli już jakieś są), a co więcej są zalecane przez rozmaite gremia zajmujące się dobrymi praktykami w zarządzaniu bezpieczeństwem (ISO, NIST itd). Jednakże podejście jakościowe czy też eksperckie zawiera wiele niedoskonałości logicznych i pułapek, które niejako kumulują się, a efekty amplifikowane są przez pułapki naszej natury, w które wpadają tygrysy cyberbezpieczeństwa.

Pułapka zafiksowania (zakotwiczenia)

Ten fenomen z psychologii polega na tym, że nasz umysł bardzo szybko przyzwyczaja się (zafiksowuje, kotwiczy) do początkowej wartości, jaką sobie obieramy by coś oszacować. Co prawda, po dalszej analizie korygujemy początkowe wartości, z których wyszliśmy, ale znowu robimy to w sposób niedostateczny, niedokorygowujemy (ang. underadjusting). W ten sposób, jeśli na początku obierzemy jakąś baaaardzo fałszywą wartość to nawet po dłuższej analizie, zafałszujemy wyniki.

Iluzja wiedzy

Często eksperci bazują na swoim doświadczeniu, zakładając, że wiedza sama niejako się buduje z czasem (z wiekiem?). Rzadko, który ekspert robi sobie “rachunek sumienia” reasumując i rewidując własne przekonania, nabyte z czasem, które uważa za wiedzę. Philip Tetlock uważa, że ludzki umysł zawodzi w sprawach związanych z prawdopodobieństwem, ponieważ dla nas naturalne jest myślenie deterministyczne - skoro tyle lat pracujemy w branży, no to chyba jednak już wiemy i mamy cholernie dużo gotowych odpowiedzi w naszym eksperckim portfolio. Już Daniel Kahneman i Amos Tversky w opublikowanym w 1971 roku artykule “Belief in the Law of Small Numbers” udowodnili, że nawet specjaliści znający rachunek prawdopodobieństwa i statystykę, wpadają w pułapkę własnej intuicji głównie przeszacowując szanse wystąpienia jakiegoś zjawiska. Problem z ekspertami jest taki, że mamy tendencję do zbierania milionów detali informacji w naszych głowach i intuicyjnie przekładamy to na umiejętność (w naszym mniemaniu) prognozowania zdarzeń związanych z tymi detalami. Przykładowo, doskonały pentester, admin firewalli, analityk incydentów bezpieczeństwa ma niewielkie zdolności do tego by prawidłowo szacować przyszłe zdarzenia związane z cyberbezpieczeństwem - aczkolwiek, natychmiast i naturalnie przychodzi nam ta konotacja - że kto jak nie taki ekspert powinien wnieść sporo do zarządzania ryzykiem bezpieczeństwa IT.

W 2010 roku Narodowe Biuro Badań Ekonomicznych w USA (national Bureau of Economic Research) zapytało wybranych CFO aby zaproponowali swoje prognozy i estymacje rocznych zysków firm z S&P500. Zaproponowano estymacje w przedziale wartości minimalnej i maksymalnej, na tyle szerokim, że państwo CFOsi uważali że mają 80% pewności, iż taki przedział zawiera prawidłową estymację. Okazało się, że tylko 33% z badanej populacji CFO udało się zmieścić w swoich przedziałach. Co więcej, tylko 20% z nich uważało, że ich estymacje mogły nie być trafne. A racji nie miało 67%. Efekt zbytniej pewności siebie. Tutaj znowu z pomocą przychodzą badania panów Kahnemana i Tverskiego, którzy dowodzą, że generalnie jako ludzie, jesteśmy zbyt pewni siebie niezależnie od profesji, w ferowaniu wyroków dotyczących przyszłych zdarzeń.

Subiektywna percepcja

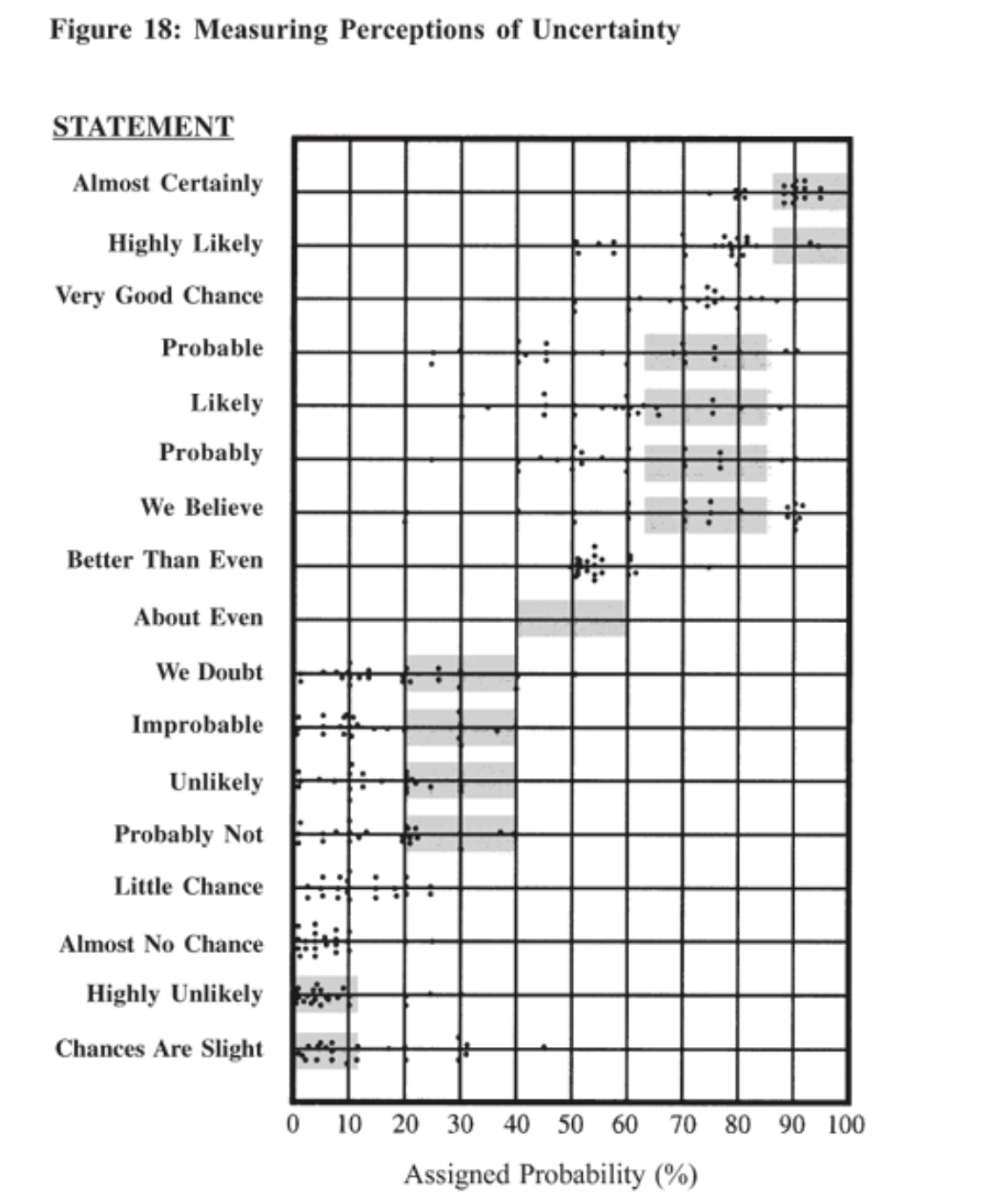

Tutaj, znowu nawiążę do naszych naturalnych inklinacji rozpatrywania problemów związanych z prognozami na podstawie subiektywnie interpretowanych danych i subiektywnego rozumienia pojęć. W odtajnionej i niezwykle interesującej publikacji CIA “Psychology of Intellligence Analysis” z 1999 roku, Richard J. Heuer, Jr opisał wyniki eksperymentu, w którym dwudziestu trzech oficerów NATO poproszono o podanie procentowej wartości prawdopodobieństwa wystąpienia darzeń opisanych jako “highly unlikely..”, “likely..” itd. (strona 155, fig. 18). Jak widać, zdarzenie ocenione jako “Highly Likely” zawiera się w przedziale od 50%-100%, “Likely” - 30%-80%, a “Chances are slight” od 0%-50%. W tym ćwiczeniu chodziło o udowodnienie, że raporty wywiadowcze zawierające dwuznaczne, niedookreślone oceny mają niską jakość i albo zostaną potraktowane niepoważnie (zbagatelizowane) albo w inny sposób zostaną źle zinterpretowane. To samo dotyczy każdego innego raportu z dowolnej dziedziny, wymagającej analiz ryzyka, czy innej prognostyki, czyli oceny, szacowania prawdopodobieństwa i szans wystąpienia niekorzystnych zdarzeń.

Podsumowanie

W całym tym artykule, starałem się przedstawić zagrożenia i pułapki związane z naszą własną ludzką naturą, zapędzające nas w kozi róg, kiedy nie zachowując należytej czujności, z biegu zabieramy się za analizy ryzyka. A te, jak i inne prognozowanie różnych zdarzeń, nie są zadaniami ani intuicyjnymi ani łatwymi. Wymagają nie tylko zmiany sposobu myślenia i podejścia do analiz ryzyka, ale i pewnego treningu, polegającego na weryfikacji wyników. Pozwoli to, po prostu lepiej wykonywać nasze zadania i dostarczać dobrych jakościowo i możliwie trafnych danych, na podstawie których bedą podejmowane ważne decyzje w przedsiębiorstwie.

Doświadczenia

Dawniej, pracując nad tematami związanymi z bezpieczeństwem IT (w różnych rolach), wielokrotnie miałem głębokie poczucie że “coś, gdzieś jest jakoś nie tak”, kiedy ślęczałem nad jakimiś raportami audytowymi pełnymi heat-map, wymyślanymi metodykami mającymi jakoś skwantyfikować ryzyka związane z funkcjonowaniem IT i bezpieczeństwem tegoż. Analizy scenariuszowe były koszmarnie rozwlekłe, czasochłonne, wymagające mnóstwa danych, pełne kwantyfikatorów, i nie dawały pełnego obrazu, tylko wycinki, dlatego nigdy nie było mi dane ani ich zastosować, ani z nimi poważnie popracować.

Metodyki audytorskie, z którymi miałem do czynienia, zawsze były mniejszymi bądź większymi rozwinięciami podejścia jakościowego/eksperckiego. Analizy te, dawały jakiś ogólny obraz, który był nawet poprawny, jeśli poprawnie wypracowaliśmy profil zagrożeń. Aczkolwiek nigdy nie było specjalnie ważne. Nadal jednak miałem poczucie, że ogólnie to wróżymy z trochę eksperckich fusów i strzelamy w ciemność. Taki wewnętrzny problem z opisem rzeczywistości, zawierającym się w jakichś labelkach czy cyferkach obranych dla_porządku_bez zastosowania metody naukowej. A każdy ten porządek_ mógł potem ustawić jak chciał. W dodatku, wyniki takie, w najlepszym razie, były weryfikowane raz na rok, podczas kolejnych audytów czy przeglądów, kiedy dawno zapomniano już, o co właściwie chodziło i skąd się wzięło to co znalazło się w raporcie z poprzedniego roku.

Lektury

Zacząłem grzebać po księgarniach i w internecie. Pierwszą rzeczą na jaką się natknąłem była metodyka FAIR, jeszcze w 2012 roku, która rozbijała na czynniki pierwsze proste “równanie”: zagrożenie X podatność = ryzyko na czynniki i w anaizie uwzględniała przynajmniej rozkład normalny przy rozważaniach łatwości realizacji np. włamu. Po jakimś czasie kupiłem pierwszą książkę na ten temat:

- J. Freund, J. Jones “Measuring and managing information risk” - autorzy to twórcy tej metodyki, metodycznie rozpoczynający swoją książkę od przedstawienia podstaw i uzasadnienia przyjętego podejścia; Szybko przekonałem się, że bez przypomnienia sobie podstaw rachunku statystycznego, prawdopodobieństwa i pewnego rozwinięcia ogólnego, nie będę w stanie w pełni ogarnąć i zrozumieć do czego dążę. Mój mózg nieprzyzwyczajony, już wtedy protestował, ale wtedy pojawiła się:

- D.W. Hubbard “How to measure anything: Finding the Value of “Intangibles” in Business”, Z racji branży, w której funkcjonowałem, szybko przeszedłem do meritum:

- D.W. Hubbard, R. Seiersen “How to measure anything in Cybersecurity Risk”, która odkryła przede mną piękno analiz z użyciem twierdzenia Bayesa do rozpatrywania zdarzeń współzależnych, metody Monte Carlo do symulacji sparametryzowanych rozkładów i zastosowania różnych rozkładów do różnych przypadków w IT (binarny, normalny, logartymiczny normalny, beta); Jakiś czas temu przeczytałem naprawdę doskonałą, nowatorską i kapitalną książkę SF:

- „Ognisty deszcz” Petera Wattsa, w którym autor na osnowę konstrukcji swojej powieści wykorzystał twórczo ekstrapolacje nowoczesnych odkryć i dokonań w nauce, technice, ale także w obszarze ludzkiej psychologii i psychiatrii. Co więcej, wydanie zawiera wszelkie przypisy do artykułów naukowych i książek, z których autor czerpał wiedzę i pomysły do książki. W ten sposób dotarłem do kolejnych dwóch kapitalnych pozycji:

- P. Tetlock, D. Gardner “Superforecasting - the art and science of prediction” - na czym polega prognozowanie, jak rozpocząć i kontynuować trening, w domu, komputer wykorzystywać do odnajdywania faktów, wnioskowania, spisywania notatek i śledzenia rozwoju wypadków. Autor kontynuje długoterminowy projekt w tym zakresie (“Goodjudgment”), gdzie każdy - ale naprawde każdy może dołączyć do zabawy i rozpocząć przygodę w przewidywanie rozwoju wypadków w jakimś zadanym temacie, biorąc pod uwagę horyzont czasowy rzędu 6-12 miesięcy, oczywiście - Najlepsi w tej zabawie są o 30% lepsi od raportów służb wywiadowczych USA. Serio.

- D. Kahneman “Pułapki myślenia”, ciężka i długo-czytana cegiełka, wracam do niej co jakiś czas, chyba kupię e-booka, bo mi się za rok-dwa rozleci od tego ciągłego zaglądania.\

Prócz powyższych pozycji, dotarłem do wielu kapitalnych publikacji naukowych i artykułów, z których również czerpałem. Do części z nich linki zamieściłem już w tym wpisie.

Co dalej

Postaram się kontynuować ten temat. Spróbuję przedstawić problemy i ułomności związane z jakościowymi metodami ryzyka, gdzie nasze ułomności w połączeniu z ograniczeniami metod jakościowych mogą prowadzić do sporych pomyłek i kłopotów w interpretacji wyników.